2016年——盘点机器学习带来的突破与发展

- +1 你赞过了

【天极网网络频道】近日,人工智能公司DeepMind开发的阿法狗升级版Master横扫中日韩顶尖围棋手,最终这次“人机大战”以60胜0负1和的战绩结束。这也意味着:对人工智能来说,人类在机器学习上的优势已经荡然无存。

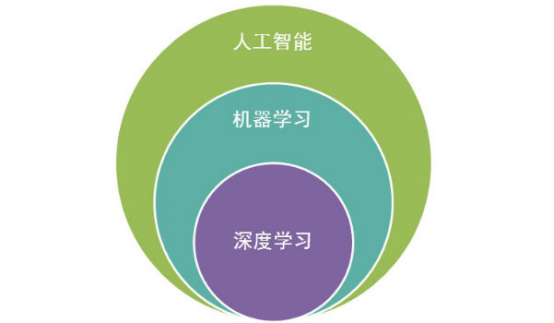

毫无疑问,这是2017年第一个引起众人关注的事件。在此之后,人工智能和机器学习将越来越火热。在强大的人工智能背后,是深度学习在起着关键作用。在云栖社区,有一篇海外机器学习专家Xavier Amatriain对2016年的总结,概述了2016年机器学习中的主要突破与发展。

2016年很可能成为历史上“机器学习最火”的一年。似乎每个人都在做机器学习领域的工作,如果不是的话,他们也正在考虑收购一家这方面的创业公司。

谷歌、Facebook和微软等科技巨头都把机器学习进行开源

至今,从谷歌宣布开源Tensor Flow项目才一年时间,它已经变成一个非常活跃的项目,被广泛应用于从药物开发到音乐制作的各个领域。此外,微软开源了CNTK,百度宣布推出PaddlePaddle。

而亚马逊则宣布,他们将在其新的AWS 机器学习平台上支持MXNet。而Facebook,不止支持一个机器学习项目,而是两个深度学习框架的开发:Torch和Caffe。另一方面,Google也支持非常成功的Keras, Facebook和Google在这方面目前打个平手。

机器学习的大量实际应用开始出现

除了机器学习研究的热潮和各大IT巨头对机器学习开源项目的大力支持外,在2016年我们还看到了机器学习的大量实际应用,这在一年前几乎难以想象。我印象特别深刻的是Wavenet运用机器学习生成的高质量音频。

我过去曾经进行过类似的研究,对于他们能够有如此出色的结果我也感到非常欣喜。还要特别指出最近在唇语阅读方面的进展,一个非常出色的视频识别应用,这在不久的将来可能是非常有用的(也许是非常可怕的)。还有,Google在机器翻译方面取得的令人印象深刻的突破。这一年中机器学习领域有这么多的进步,真是令人惊叹不已。

事实上,机器翻译并不是机器学习语言技术方面看到的唯一有趣的进步。最近,结合深层顺序网络和边际信息技术的方法来产生丰富的语言模型是非常有意思的研究。在《一种神经网络语言模型》中,Bengio团队就结合了知识图与RNN(递归神经网络)技术。在《用于大规模NLP任务的上下文LSTM模型》中,Deepmind团队将NPL(神经语言程序学)纳入到LSTM(长短期记忆人工神经网络)模型中。我们还看到了在建模语言模型注意力和记忆方面许多有趣的工作。比如,我比较推荐上次ICML上展示的《用于NLP的动态记忆网络》

巴塞罗那举行的NIPS 2016

此外,我还要谈谈在巴塞罗那举行的NIPS 2016。不幸的是,我错过这次在我家乡举行的会议。我只能以其他方式关注这次会议。而就我所了解的,这次会议中最炙手可热的两个议题可能就是《生成式对抗网络》(包括Ian Goodfellow非常受欢迎的教程)和《概率模型与深度学习的组合》

当然,深度学习也影响了这一领域,虽然我仍然不建议将深度学习作为推荐系统的默认方法。如何在实际工作中大规模的使用推荐系统是非常有趣的,比如通过像Youtube这样的产品。也就是说,在推荐系统中的一些有趣的研究与深度学习并无多大关系。今年ACM Recsys的最佳论文奖获得者《用于Top-N的本地项目间模型》就是一个使用初始无监督聚类步骤的稀疏线性方法(即SLIM)的一个有趣的扩展。此外《用于CTR预测的现场感知因子分解机》中描述了Criteo CTR预测Kaggle挑战的获胜方法。这给我们一个非常好的提示,分解机在机器学习工具包中仍然是一个出色的工具。

我还能罗列出许多机器学习研究领域在过去一年中的进步。而我没有提到任何与图像识别或加强学习相关的突破或突出的应用程序,如无人车,聊天机器人或人工智能游戏这样的例子。这些都是2016年取得的巨大进步。更不用说所有关于机器学习如何具有或可能对社会产生负面影响的争论,以及围绕算法偏差和公平性讨论的兴起。

编辑点评:

机器学习的发展将带动人工智能的快速发展,而资本、人力和各种资源也将进入这个行业。相比去年,今年人工智能将更加火热。最重要的是,人工智能作为下一代的通用计算平台,将与各种产业进行衔接,从而实现“人工智能+”,促进传统产业的新发展。

X

X

微博认证登录

微博认证登录

QQ账号登录

QQ账号登录

微信账号登录

微信账号登录